- MARTINGALES (THÉORIE DES)

- MARTINGALES (THÉORIE DES)Le mot «martingale» évoque l’idée d’une stratégie pour gagner aux jeux de hasard. Cette notion tient une place essentielle dans toute la théorie des probabilités et s’est révélée être un langage très riche dans de nombreux domaines des mathématiques; mais ce rôle n’est apparu que tout récemment.Au XVIe siècle, ce mot (qui proviendrait du provençal martegalo , du nom de la ville de Martigues) désignait une courroie qui, placée sous le ventre du cheval, relie la sangle à la muserolle pour empêcher l’animal de trop lever la tête. Pour Littré, la locution est tirée par métaphore de la bifurcation de la martingale des chevaux; mais ne faudrait-il pas voir, dans cette étymologie, l’espoir que les martingales permettraient de brider le hasard?... Il y a d’ailleurs d’autres étymologies.C’est au début du XVIIIe siècle qu’apparaît, chez Abraham De Moivre (The Doctrine of Chance , 1718, dont une première version latine date de 1711), la notion de martingale comme stratégie permettant de gagner «à coup sûr» dans un jeu équitable (pile ou face, par exemple). Citons comme exemple la martingale la plus classique, dite de D’Alembert mais d’origine beaucoup plus ancienne, relative au jeu de pile ou face, dont la règle du jeu est la suivante: On parie x francs sur pile. Si la pièce tombe sur pile, on ramasse ses x et on gagne x autres francs; si elle marque face, on perd sa mise de x francs. À chaque coup, on est libre de se retirer (ce qui revient à miser 0 F) ou de continuer à jouer.La stratégie dite de martingale est alors celle-ci:– Au 1er coup, on mise 1 franc; si on gagne, on se retire (on a donc gagné 1 F); si on perd (on a donc perdu 1 F), on continue;– Au 2e coup, on mise le double: 2 francs; si on gagne, on se retire (on a donc gagné 2 F, moins 1 F perdu au 1er coup, le gain global est encore 1 F); si on perd (on a donc perdu en tout 1 F + 2 F = 3 F), on continue;– Au 3e coup, on mise encore le double: 4 francs; si on gagne, on se retire (on a donc gagné 4 F 漣 1 F 漣 2 F = gain global 1 F); si on perd (on a donc maintenant perdu 1 F + 2 F + 4 F = 7 F), on continue en doublant sa mise...– Et ainsi de suite. Comme «ce serait bien le diable» si on ne finissait pas par gagner un coup ou l’autre, on voit que, avec cette méthode, on est «presque sûr» de gagner 1 franc, c’est-à-dire sa mise de départ.À cela, il faut ajouter une remarque: pour pouvoir utiliser sans risque une telle stratégie, il faut être riche; si on ne dispose que d’une fortune finie, la probabilité de gagner n’est plus égale à 1.Plus généralement se pose le problème suivant: pour un jeu équitable du type précédent, déterminer une stratégie qui permette de gagner presque sûrement: en misant à chaque coup la somme qu’on veut (et en interrompant le jeu à un moment bien choisi) en fonction uniquement de ce qui s’est passé les coups précédents, peut-on être presque sûr de gagner?Nous verrons (c’est le «théorème d’arrêt»), que, si la fortune du joueur est bornée, la réponse est non. Ce thème «pessimiste» de la ruine des joueurs semble apparaître pour la première fois chez Ampère, qui précise que la ruine est certaine, quel que soit le système de jeu employé.La formulation mathématique moderne remonte à P. Lévy (1935, 1937: condition C de Paul Lévy) et à Jean Ville (1939), qui introduit en ce sens le terme de martingale. À cette époque, le lien entre le calcul des probabilités et la théorie de l’intégration venait certes d’être mis en évidence, mais les jeux de hasard constituaient encore un support essentiel des probabilités. C’est J. L. Doob qui a élaboré, après la Seconde Guerre mondiale, les théorèmes de convergences des martingales.Aujourd’hui, l’utilisation de la notion de martingale en mathématiques est très fréquente, y compris dans des domaines qui n’ont apparemment «rien à voir» avec les jeux de hasard. Donnons-en quelques idées.Martingales et processus stochastiquesRappelons qu’un processus stochastique est une famille (Xt ) de variables aléatoires réelles, t 捻 R ou N, ce qui peut s’interpréter en d’autres termes comme une fonction définie sur R ou N et «dépendant du hasard»:

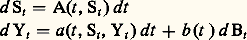

Parmi les processus aux propriétés les plus remarquables, et qui interviennent souvent dans l’approche de phénomènes réels, figurent en particulier le mouvement brownien et le processus de Poisson (cf. processus STOCHASTIQUES). On peut dire que ces processus «cumulent» des propriétés (importantes et commodes) qu’on retrouve dans beaucoup de phénomènes. Prenons le cas du mouvement brownien:– c’est un processus à accroissements indépendants et stationnaires,– c’est un processus gaussien (ou laplacien),– c’est un processus de Markov,– c’est aussi une martingale.Les propriétés remarquables du brownien «proviennent», pourrait-on dire de manière un peu impropre, tantôt d’un de ces caractères, tantôt d’un autre...Il est donc naturel d’étudier chacun de ces types de processus et de voir quelles propriétés du mouvement brownien ils conservent. D’autre part, ces différentes classes de processus ont des liens entre elles: par exemple, l’étude des martingales permet (et c’est une motivation importante aujourd’hui) d’enrichir la connaissance des processus de Markov.Les martingales en analyseLes martingales servent à élucider des problèmes importants en dehors de la théorie des probabilités. Citons un exemple: celui des fonctions harmoniques (cf. POTENTIEL ET FONCTIONS HARMONIQUES, calcul des PROBABILITÉS, chap. 11).L’étude de diverses classes de fonctions harmoniques, par exemple la résolution de «problèmes de Dirichlet» (déterminer des fonctions qui soient harmoniques à l’intérieur d’un certain domaine et admettent un comportement donné à la frontière de ce domaine), peut être effectuée à l’aide de la notion de martingale. Dans certains contextes, on ne sait pas obtenir de réponses à ces problèmes «purement analytiques» sans utiliser la notion «purement probabiliste (sic )» de martingale.Cela constitue une partie de la théorie du potentiel, qui témoigne d’un rapport étroit entre l’analyse et les probabilités.Un exemple de martingaleen mathématiques appliquées:le filtrage d’un signalUne modélisation de nombreux phénomènes (physiques, biologiques, démographiques...) utilise des processus stochastiques pour reconstituer ou au moins donner une estimation raisonnable (au vu d’observations) d’un signal inconnu évoluant au cours du temps et déformé par des perturbations aléatoires, les «bruits» (cf. théorie de l’INFORMATION). Pour traiter un tel problème, on utilise couramment une modélisation du type suivant:Soit Yt l’observation à l’instant t , St le signal et (Bt ), t 閭 0, un mouvement brownien (donc une martingale) représentant la perturbation aléatoire; les évolutions de Yt et de St au cours du temps sont données à partir d’équations différentielles du type:

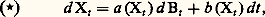

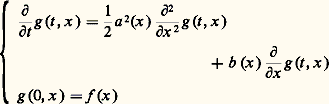

Parmi les processus aux propriétés les plus remarquables, et qui interviennent souvent dans l’approche de phénomènes réels, figurent en particulier le mouvement brownien et le processus de Poisson (cf. processus STOCHASTIQUES). On peut dire que ces processus «cumulent» des propriétés (importantes et commodes) qu’on retrouve dans beaucoup de phénomènes. Prenons le cas du mouvement brownien:– c’est un processus à accroissements indépendants et stationnaires,– c’est un processus gaussien (ou laplacien),– c’est un processus de Markov,– c’est aussi une martingale.Les propriétés remarquables du brownien «proviennent», pourrait-on dire de manière un peu impropre, tantôt d’un de ces caractères, tantôt d’un autre...Il est donc naturel d’étudier chacun de ces types de processus et de voir quelles propriétés du mouvement brownien ils conservent. D’autre part, ces différentes classes de processus ont des liens entre elles: par exemple, l’étude des martingales permet (et c’est une motivation importante aujourd’hui) d’enrichir la connaissance des processus de Markov.Les martingales en analyseLes martingales servent à élucider des problèmes importants en dehors de la théorie des probabilités. Citons un exemple: celui des fonctions harmoniques (cf. POTENTIEL ET FONCTIONS HARMONIQUES, calcul des PROBABILITÉS, chap. 11).L’étude de diverses classes de fonctions harmoniques, par exemple la résolution de «problèmes de Dirichlet» (déterminer des fonctions qui soient harmoniques à l’intérieur d’un certain domaine et admettent un comportement donné à la frontière de ce domaine), peut être effectuée à l’aide de la notion de martingale. Dans certains contextes, on ne sait pas obtenir de réponses à ces problèmes «purement analytiques» sans utiliser la notion «purement probabiliste (sic )» de martingale.Cela constitue une partie de la théorie du potentiel, qui témoigne d’un rapport étroit entre l’analyse et les probabilités.Un exemple de martingaleen mathématiques appliquées:le filtrage d’un signalUne modélisation de nombreux phénomènes (physiques, biologiques, démographiques...) utilise des processus stochastiques pour reconstituer ou au moins donner une estimation raisonnable (au vu d’observations) d’un signal inconnu évoluant au cours du temps et déformé par des perturbations aléatoires, les «bruits» (cf. théorie de l’INFORMATION). Pour traiter un tel problème, on utilise couramment une modélisation du type suivant:Soit Yt l’observation à l’instant t , St le signal et (Bt ), t 閭 0, un mouvement brownien (donc une martingale) représentant la perturbation aléatoire; les évolutions de Yt et de St au cours du temps sont données à partir d’équations différentielles du type: où il faut lire la première relation comme:

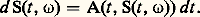

où il faut lire la première relation comme: La première équation est, pour 諸 fixé, une équation différentielle ordinaire. Par contre, à cause du terme d Bt (pour des raisons qu’on verra plus loin), on ne peut travailler à 諸 fixé dans la deuxième équation et il est nécessaire, pour en définir des solutions et effectuer des calculs, d’introduire un calcul stochastique qui utilise la théorie des martingales à temps continu.On utilisera dans ce qui suit la terminologie et les notations introduites dans les articles INTÉGRATION ET MESURE, calcul des PROBABILITÉS et processus STOCHASTIQUES.1. Espérances conditionnellesLe problème de l’espérance conditionnelle répond à la question suivante:Soit ( 行, 杻, p ) un espace de probabilité et soit 龍 une sous-tribu de 杻: typiquement, face=F0021 龍 est la tribu 靖(Y1, ..., Yn ) engendrée par une famille de variables aléatoires Y1, ..., Yn , c’est-à-dire intuitivement d’observations d’un phénomène aléatoire (on dit alors que 龍 exprime l’information contenue dans les observations Y1, ..., Yn ).Le problème est le suivant: si f est une variable aléatoire réelle intégrable, comment estimer au mieux le signal aléatoire f , connaissant les observations résumées par la tribu 龍?L’espérance conditionnelle E(f | 龍) nous donnera la solution.Définition . Soit A un événement de probabilité non nulle; nous appelons espérance conditionnelle de f sachant que A est réalisé , et nous notons E(f |A), la moyenne de f sur A, c’est-à-dire:

La première équation est, pour 諸 fixé, une équation différentielle ordinaire. Par contre, à cause du terme d Bt (pour des raisons qu’on verra plus loin), on ne peut travailler à 諸 fixé dans la deuxième équation et il est nécessaire, pour en définir des solutions et effectuer des calculs, d’introduire un calcul stochastique qui utilise la théorie des martingales à temps continu.On utilisera dans ce qui suit la terminologie et les notations introduites dans les articles INTÉGRATION ET MESURE, calcul des PROBABILITÉS et processus STOCHASTIQUES.1. Espérances conditionnellesLe problème de l’espérance conditionnelle répond à la question suivante:Soit ( 行, 杻, p ) un espace de probabilité et soit 龍 une sous-tribu de 杻: typiquement, face=F0021 龍 est la tribu 靖(Y1, ..., Yn ) engendrée par une famille de variables aléatoires Y1, ..., Yn , c’est-à-dire intuitivement d’observations d’un phénomène aléatoire (on dit alors que 龍 exprime l’information contenue dans les observations Y1, ..., Yn ).Le problème est le suivant: si f est une variable aléatoire réelle intégrable, comment estimer au mieux le signal aléatoire f , connaissant les observations résumées par la tribu 龍?L’espérance conditionnelle E(f | 龍) nous donnera la solution.Définition . Soit A un événement de probabilité non nulle; nous appelons espérance conditionnelle de f sachant que A est réalisé , et nous notons E(f |A), la moyenne de f sur A, c’est-à-dire: Si f = 1B est une fonction indicatrice, on retrouve la probabilité conditionnelle:

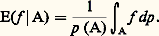

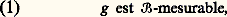

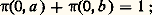

Si f = 1B est une fonction indicatrice, on retrouve la probabilité conditionnelle: lorsque A est de probabilité nulle, on convient que E(f |A) = 0.Définition . Si 戮 est une partition dénombrable de 行, c’est-à-dire une famille dénombrable d’événementsAi, i 捻 N, disjoints et dont la réunion est égale à 行, nous appelons espérance conditionnelle de f relativement à 戮, et nous notons E(f | 戮), la variable aléatoire réelle qui, sur chaque ensemble Ai , i 捻 N, est constante et égale à E(f |Ai ), c’est-à-dire à la moyenne de f sur Ai .L’espérance conditionnelle E(f | 戮) est alors caractérisée presque partout par les deux propriétés suivantes:

lorsque A est de probabilité nulle, on convient que E(f |A) = 0.Définition . Si 戮 est une partition dénombrable de 行, c’est-à-dire une famille dénombrable d’événementsAi, i 捻 N, disjoints et dont la réunion est égale à 行, nous appelons espérance conditionnelle de f relativement à 戮, et nous notons E(f | 戮), la variable aléatoire réelle qui, sur chaque ensemble Ai , i 捻 N, est constante et égale à E(f |Ai ), c’est-à-dire à la moyenne de f sur Ai .L’espérance conditionnelle E(f | 戮) est alors caractérisée presque partout par les deux propriétés suivantes: Plus généralement, si 龍 est une sous-tribu de 杻 et f une variable aléatoire réelle intégrable, on montre qu’il existe toujours une variable aléatoire g telle que:

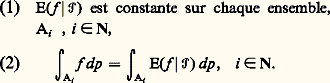

Plus généralement, si 龍 est une sous-tribu de 杻 et f une variable aléatoire réelle intégrable, on montre qu’il existe toujours une variable aléatoire g telle que:

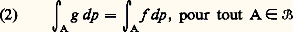

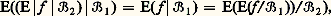

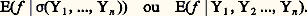

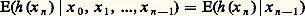

(g n’est définie que presque sûrement, mais nous n’insisterons pas sur cette subtilité).Une telle variable aléatoire, remplissant les conditions (1) et (2), est notée E(f | 龍); on peut remarquer que, si 龍 est la tribu engendrée par une partition 戮, on a E(f | 龍) = E(f | 戮) presque sûrement.Propriétés fondamentalesL’espérance conditionnelle d’une variable aléatoire réelle intégrable est encore une variable aléatoire réelle, alors que l’espérance d’une variable aléatoire réelle intégrable est un nombre réel; à cette seule différence près, les propriétés de l’espérance conditionnelle sont analogues à celles d’une espérance (linéarité, passage à la limite croissante, théorème de convergence dominée...).D’autres propriétés sont particulières à l’espérance conditionnelle: elles indiquent que l’espérance conditionnelle «filtre» f selon l’information contenue dans 龍. On a, en particulier, les deux cas extrêmes:En outre:– le conditionnement successif par rapport à des tribus emboîtées revient au seul conditionnement relatif à la tribu la moins fine, ce qui s’écrit: si 龍1 說 龍2, alors:

(g n’est définie que presque sûrement, mais nous n’insisterons pas sur cette subtilité).Une telle variable aléatoire, remplissant les conditions (1) et (2), est notée E(f | 龍); on peut remarquer que, si 龍 est la tribu engendrée par une partition 戮, on a E(f | 龍) = E(f | 戮) presque sûrement.Propriétés fondamentalesL’espérance conditionnelle d’une variable aléatoire réelle intégrable est encore une variable aléatoire réelle, alors que l’espérance d’une variable aléatoire réelle intégrable est un nombre réel; à cette seule différence près, les propriétés de l’espérance conditionnelle sont analogues à celles d’une espérance (linéarité, passage à la limite croissante, théorème de convergence dominée...).D’autres propriétés sont particulières à l’espérance conditionnelle: elles indiquent que l’espérance conditionnelle «filtre» f selon l’information contenue dans 龍. On a, en particulier, les deux cas extrêmes:En outre:– le conditionnement successif par rapport à des tribus emboîtées revient au seul conditionnement relatif à la tribu la moins fine, ce qui s’écrit: si 龍1 說 龍2, alors: toutes ces égalités étant vraies presque sûrement.Remarquons enfin que, si f est positive et non intégrable, on peut définir par passage à la limite E(f | 龍) pour toute sous-tribu 龍 de 杻.Si 龍 est la tribu engendrée par des variables aléatoires Y1, ..., Yn , on note indifféremment:

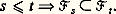

toutes ces égalités étant vraies presque sûrement.Remarquons enfin que, si f est positive et non intégrable, on peut définir par passage à la limite E(f | 龍) pour toute sous-tribu 龍 de 杻.Si 龍 est la tribu engendrée par des variables aléatoires Y1, ..., Yn , on note indifféremment: 2. Processus stochastiques et martingalesSoit ( 行, 杻, p ) un espace probabilisé et I un intervalle de N ou de R+; une famille (Xt ), t 捻 I, de variables aléatoires réelles est appelée processus stochastique à valeurs réelles à temps discret si I 說 N et à temps continu si I 說 R. Souvent un processus stochastique représente la modélisation d’un phénomène aléatoire évoluant au cours du temps (représenté par le paramètre t ); pour 諸 fixé, la fonction de t : tXt ( 諸) est appelée trajectoire du processus ; si I est un intervalle de R+ , on dit que le processus est continu si presque toutes ses trajectoires sont continues.FiltrationÀ chaque processus stochastique (Xt ), t 捻 I, sont liées de façon naturelle les tribus 杻t X, engendrées par les variables Xs pour s 諒 t , qui représentent toute l’information fournie par le processus jusqu’à l’instant t ; une telle famille (face=F0021 杻t X), t 捻 I, est une filtration .De façon plus précise, une filtration indexée par I est une famille (face=F0021 杻t ), t 捻 I, de sous-tribus de 杻, c’est-à-dire 杻t 說 杻, possédant la propriété de croissance suivante:

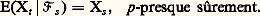

2. Processus stochastiques et martingalesSoit ( 行, 杻, p ) un espace probabilisé et I un intervalle de N ou de R+; une famille (Xt ), t 捻 I, de variables aléatoires réelles est appelée processus stochastique à valeurs réelles à temps discret si I 說 N et à temps continu si I 說 R. Souvent un processus stochastique représente la modélisation d’un phénomène aléatoire évoluant au cours du temps (représenté par le paramètre t ); pour 諸 fixé, la fonction de t : tXt ( 諸) est appelée trajectoire du processus ; si I est un intervalle de R+ , on dit que le processus est continu si presque toutes ses trajectoires sont continues.FiltrationÀ chaque processus stochastique (Xt ), t 捻 I, sont liées de façon naturelle les tribus 杻t X, engendrées par les variables Xs pour s 諒 t , qui représentent toute l’information fournie par le processus jusqu’à l’instant t ; une telle famille (face=F0021 杻t X), t 捻 I, est une filtration .De façon plus précise, une filtration indexée par I est une famille (face=F0021 杻t ), t 捻 I, de sous-tribus de 杻, c’est-à-dire 杻t 說 杻, possédant la propriété de croissance suivante: Un processus stochastique (Xt ), t 捻 I, est dit adapté à une filtration (face=F0021 杻t ), t 捻 I, si, pour tout t 捻 I, la variable aléatoire Xt est 杻t -mesurable; tout processus stochastique (Xt ), t 捻 I, est évidemment adapté à sa filtration naturelle (face=F0021 杻t X), t 捻 I.Si (Xt ) est adapté à (face=F0021 杻t ), la filtration considérée est plus fine que la filtration naturelle associée à (Xt ). Pratiquement, dans de nombreux cas, cela correspond à la situation suivante: on observe un phénomène aléatoire dépendant du temps; alors (face=F0021 杻t ) correspond à l’information contenue dans «tout le phénomène» jusqu’à l’instant t (en d’autres termes, c’est la filtration associée à un «gros» processus représentant le phénomène), alors que 杻t X ne correspond qu’à des observations partielles de ce phénomène.DéfinitionsSoit (Xt ), t 捻 I, un processus stochastique adapté à une filtration (face=F0021 杻t ), t 捻 I, et tel que, pour tout t 捻 I, Xt soit intégrable, c’est-à-dire E(|Xt |) 麗 秊.

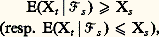

Un processus stochastique (Xt ), t 捻 I, est dit adapté à une filtration (face=F0021 杻t ), t 捻 I, si, pour tout t 捻 I, la variable aléatoire Xt est 杻t -mesurable; tout processus stochastique (Xt ), t 捻 I, est évidemment adapté à sa filtration naturelle (face=F0021 杻t X), t 捻 I.Si (Xt ) est adapté à (face=F0021 杻t ), la filtration considérée est plus fine que la filtration naturelle associée à (Xt ). Pratiquement, dans de nombreux cas, cela correspond à la situation suivante: on observe un phénomène aléatoire dépendant du temps; alors (face=F0021 杻t ) correspond à l’information contenue dans «tout le phénomène» jusqu’à l’instant t (en d’autres termes, c’est la filtration associée à un «gros» processus représentant le phénomène), alors que 杻t X ne correspond qu’à des observations partielles de ce phénomène.DéfinitionsSoit (Xt ), t 捻 I, un processus stochastique adapté à une filtration (face=F0021 杻t ), t 捻 I, et tel que, pour tout t 捻 I, Xt soit intégrable, c’est-à-dire E(|Xt |) 麗 秊. Si l’égalité ci-dessus est remplacée par:

Si l’égalité ci-dessus est remplacée par: on dit que (Xt , 杻t ) est une sous-martingale (resp. une sur-martingale ).Ainsi une martingale représente-t-elle un jeu «équitable»: si Xt désigne le gain cumulé par le joueur au temps t , l’égalité E(Xt | 杻s ) = Xs , pour tout t 閭 s , signifie que, connaissant 杻s (c’est-à-dire sans savoir plus que ce qui s’est passé jusqu’au temps s ), on n’a pas plus de chances d’augmenter que de diminuer ses gains dans l’avenir.En d’autres termes, en personnifiant un peu ce processus, on peut dire qu’il choisit tout simplement comme estimé de son avenir (au vu de son histoire) son état à l’instant présent: il n’est ni ambitieux, ni dépressif (une sur-martingale est dépressive, une sous-martingale ambitieuse).ExemplesCommençons par des exemples issus du jeu de pile ou face avec une pièce non truquée: un joueur joue pile («contre la banque») selon les règles habituelles.Notons X0 = 0 et Yk le gain (ou la perte) obtenu au k -ième coup; alors:

on dit que (Xt , 杻t ) est une sous-martingale (resp. une sur-martingale ).Ainsi une martingale représente-t-elle un jeu «équitable»: si Xt désigne le gain cumulé par le joueur au temps t , l’égalité E(Xt | 杻s ) = Xs , pour tout t 閭 s , signifie que, connaissant 杻s (c’est-à-dire sans savoir plus que ce qui s’est passé jusqu’au temps s ), on n’a pas plus de chances d’augmenter que de diminuer ses gains dans l’avenir.En d’autres termes, en personnifiant un peu ce processus, on peut dire qu’il choisit tout simplement comme estimé de son avenir (au vu de son histoire) son état à l’instant présent: il n’est ni ambitieux, ni dépressif (une sur-martingale est dépressive, une sous-martingale ambitieuse).ExemplesCommençons par des exemples issus du jeu de pile ou face avec une pièce non truquée: un joueur joue pile («contre la banque») selon les règles habituelles.Notons X0 = 0 et Yk le gain (ou la perte) obtenu au k -ième coup; alors: est le gain cumulé au n -ième coup.Exemple 1 : stratégie «bête», du moins apparemment. À chaque coup, le joueur mise 1 F sur pile, indépendamment de ce qui s’est passé avant: en termes mathématiques, les Y k sont des variables aléatoires indépendantes et Y k = 梁 1 avec même probabilité 1/2. On vérifie immédiatement que:

est le gain cumulé au n -ième coup.Exemple 1 : stratégie «bête», du moins apparemment. À chaque coup, le joueur mise 1 F sur pile, indépendamment de ce qui s’est passé avant: en termes mathématiques, les Y k sont des variables aléatoires indépendantes et Y k = 梁 1 avec même probabilité 1/2. On vérifie immédiatement que: Plus généralement, dès que (Yk ) est une suite de variables aléatoires indépendantes et centrées et que Xn = Y1 + ... + Yn , alors (Xn , 杻n X) est une martingale. C’est cet exemple qui a inspiré les travaux de Paul Lévy.Exemple 2 : stratégie «futée», du moins apparemment; c’est celle de l’introduction. Le joueur, pariant toujours sur pile, cesse le jeu dès sa première victoire (c’est-à-dire qu’à partir de ce moment il mise zéro franc) et double sa mise à chaque fois qu’il a perdu. Autrement dit Y1 = 梁 1 avec même probabilité 1/2.Si Y1 = 1 et, par suite, X1 = 1, alors Y2 = Y3 = ... = 0; par contre, si Y1 = 漣 1, alors Y2 = 梁 2 avec même probabilité, et ainsi de suite.On vérifie que E(Yn | 杻Yn-1 ) = 0, donc que E(Xn | 杻Y n-1) = Xn-1 , et (Xn , 杻 nX) est bien une martingale.Les exemples 3 et 4 vont faire le lien avec les fonctions harmoniques.Exemple 3 : promenade dans un carré. On considère un cube C dans Zd :

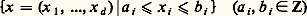

Plus généralement, dès que (Yk ) est une suite de variables aléatoires indépendantes et centrées et que Xn = Y1 + ... + Yn , alors (Xn , 杻n X) est une martingale. C’est cet exemple qui a inspiré les travaux de Paul Lévy.Exemple 2 : stratégie «futée», du moins apparemment; c’est celle de l’introduction. Le joueur, pariant toujours sur pile, cesse le jeu dès sa première victoire (c’est-à-dire qu’à partir de ce moment il mise zéro franc) et double sa mise à chaque fois qu’il a perdu. Autrement dit Y1 = 梁 1 avec même probabilité 1/2.Si Y1 = 1 et, par suite, X1 = 1, alors Y2 = Y3 = ... = 0; par contre, si Y1 = 漣 1, alors Y2 = 梁 2 avec même probabilité, et ainsi de suite.On vérifie que E(Yn | 杻Yn-1 ) = 0, donc que E(Xn | 杻Y n-1) = Xn-1 , et (Xn , 杻 nX) est bien une martingale.Les exemples 3 et 4 vont faire le lien avec les fonctions harmoniques.Exemple 3 : promenade dans un carré. On considère un cube C dans Zd : et notons 煉C le bord du cube. Nous ferons les dessins et les calculs dans le cas d = 2 pour simplifier (fig. 1).On dit qu’une fonction h définie sur C est harmonique si, pour tout élément 﨡 = (x , y ) de l’intérieur C 漣 煉C du cube, h ( 﨡) est égal à la moyenne des valeurs de h sur les quatre plus proches voisins de 﨡 dans C:

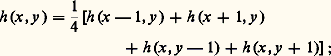

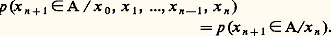

et notons 煉C le bord du cube. Nous ferons les dessins et les calculs dans le cas d = 2 pour simplifier (fig. 1).On dit qu’une fonction h définie sur C est harmonique si, pour tout élément 﨡 = (x , y ) de l’intérieur C 漣 煉C du cube, h ( 﨡) est égal à la moyenne des valeurs de h sur les quatre plus proches voisins de 﨡 dans C: en particulier, les fonctions coordonnées sont évidemment harmoniques.Considérons alors le processus suivant sur C (disons le mouvement d’une particule): une particule se trouve à l’instant 0 en un point fixé 﨡 de C, soit x 0 = 﨡. Au coup suivant, elle saute aléatoirement en un de ses voisins de manière équiprobable (probabilité 1/4 pour chacun) et ainsi de suite; sa position x n+1 à l’instant n + 1 est obtenue à partir de la position x n à l’instant n (et en oubliant tout ce qui s’est passé avant) par un saut équiprobable sur l’un de ses quatre petits voisins (!), si x n reste à l’intérieur du cube; lorsque x n parvient sur le bord, elle y reste.On peut montrer que cela définit bien un processus stochastique et que, si l’on pose Xn = h (x n ), alors (Xn , 杻n X) est une martingale.Remarquons que, dans le cas d = 1, le cube C étant l’intervalle [a , b ] (supposons a 麗 0, b 礪 0), cela correspond encore à un jeu de pile ou face: interprétant |a | comme la fortune initiale du joueur et b comme celle de la banque, on voit que le jeu s’arrête quand le joueur a perdu |a | francs (c’est-à-dire qu’il est ruiné) ou quand il a gagné b francs (c’est-à-dire qu’il a fait «sauter la banque»).Exemple 4 : fonctions harmoniques des chaînes de Markov. C’est une généralisation du précédent. Rappelons brièvement ce qu’est une chaîne de Markov: une particule se déplace sur un espace d’«états» E en sautant; elle part, disons, de 﨡 捻 E, soit x 0 = 﨡, et le passage de l’instant n à l’instant n + 1 ne dépend que de la position x n à l’instant n et non de ce qui s’était passé avant, soit:

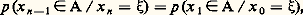

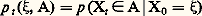

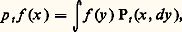

en particulier, les fonctions coordonnées sont évidemment harmoniques.Considérons alors le processus suivant sur C (disons le mouvement d’une particule): une particule se trouve à l’instant 0 en un point fixé 﨡 de C, soit x 0 = 﨡. Au coup suivant, elle saute aléatoirement en un de ses voisins de manière équiprobable (probabilité 1/4 pour chacun) et ainsi de suite; sa position x n+1 à l’instant n + 1 est obtenue à partir de la position x n à l’instant n (et en oubliant tout ce qui s’est passé avant) par un saut équiprobable sur l’un de ses quatre petits voisins (!), si x n reste à l’intérieur du cube; lorsque x n parvient sur le bord, elle y reste.On peut montrer que cela définit bien un processus stochastique et que, si l’on pose Xn = h (x n ), alors (Xn , 杻n X) est une martingale.Remarquons que, dans le cas d = 1, le cube C étant l’intervalle [a , b ] (supposons a 麗 0, b 礪 0), cela correspond encore à un jeu de pile ou face: interprétant |a | comme la fortune initiale du joueur et b comme celle de la banque, on voit que le jeu s’arrête quand le joueur a perdu |a | francs (c’est-à-dire qu’il est ruiné) ou quand il a gagné b francs (c’est-à-dire qu’il a fait «sauter la banque»).Exemple 4 : fonctions harmoniques des chaînes de Markov. C’est une généralisation du précédent. Rappelons brièvement ce qu’est une chaîne de Markov: une particule se déplace sur un espace d’«états» E en sautant; elle part, disons, de 﨡 捻 E, soit x 0 = 﨡, et le passage de l’instant n à l’instant n + 1 ne dépend que de la position x n à l’instant n et non de ce qui s’était passé avant, soit: Supposant la chaîne homogène dans le temps, c’est-à-dire:

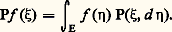

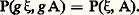

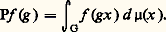

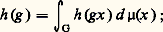

Supposant la chaîne homogène dans le temps, c’est-à-dire: on note cette quantité P( 﨡, A): elle indique comment se fait la transition de l’instant n à l’instant n + 1. Pour 﨡 fixé, P( 﨡, .) est une probabilité appelée probabilité de transition de la chaîne.Notons alors, pour toute fonction f sur E,

on note cette quantité P( 﨡, A): elle indique comment se fait la transition de l’instant n à l’instant n + 1. Pour 﨡 fixé, P( 﨡, .) est une probabilité appelée probabilité de transition de la chaîne.Notons alors, pour toute fonction f sur E, On dit qu’une fonction h est harmonique pour la chaîne de Markov (ou P-harmonique) si Ph = h . On pourrait dire, en un sens qu’il faudrait préciser, que h est une position d’équilibre pour la chaîne.

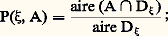

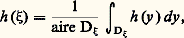

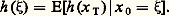

On dit qu’une fonction h est harmonique pour la chaîne de Markov (ou P-harmonique) si Ph = h . On pourrait dire, en un sens qu’il faudrait préciser, que h est une position d’équilibre pour la chaîne. puisque (x n ) est une chaîne de Markov; mais alors, par définition de la probabilité de transition, cette quantité vaut Ph (x n-1 ), donc h (x n-1 ) puisque h est P-harmonique.Remarquons que l’exemple 3 est un cas particulier de l’exemple 4: E est le cube et:– si 﨡 捻 煉C, on a P( 﨡, 﨡) = 1 et, P( 﨡, 兀) = 0 pour 兀 﨡,– si 﨡 捻 C 漣 煉C, on a P( 﨡, 兀) = 1/4 si 兀 est un voisin de 﨡 et 0 sinon.Voici un autre cas particulier qui justifie encore mieux le terme «harmonique»: prenons pour E le disque unité de R2 = C et notons D size=1﨡 le disque de centre 﨡 捻 E et de rayon 1 漣 | 﨡|; considérons la chaîne de Markov partant d’un point 﨡0 arbitraire de E et telle que le passage de l’instant n à l’instant n + 1 se fasse de la manière suivante: si x n = 﨡, la loi de x n+1 est la probabilité uniforme sur le disque du centre 﨡 et tangent au disque unité; en d’autres termes:

puisque (x n ) est une chaîne de Markov; mais alors, par définition de la probabilité de transition, cette quantité vaut Ph (x n-1 ), donc h (x n-1 ) puisque h est P-harmonique.Remarquons que l’exemple 3 est un cas particulier de l’exemple 4: E est le cube et:– si 﨡 捻 煉C, on a P( 﨡, 﨡) = 1 et, P( 﨡, 兀) = 0 pour 兀 﨡,– si 﨡 捻 C 漣 煉C, on a P( 﨡, 兀) = 1/4 si 兀 est un voisin de 﨡 et 0 sinon.Voici un autre cas particulier qui justifie encore mieux le terme «harmonique»: prenons pour E le disque unité de R2 = C et notons D size=1﨡 le disque de centre 﨡 捻 E et de rayon 1 漣 | 﨡|; considérons la chaîne de Markov partant d’un point 﨡0 arbitraire de E et telle que le passage de l’instant n à l’instant n + 1 se fasse de la manière suivante: si x n = 﨡, la loi de x n+1 est la probabilité uniforme sur le disque du centre 﨡 et tangent au disque unité; en d’autres termes: l’exemple 3 était, en quelque sorte, un analogue «discrétisé» de celui-ci.

l’exemple 3 était, en quelque sorte, un analogue «discrétisé» de celui-ci. ce qui correspond à la définition des fonctions harmoniques au sens usuel sur le disque, ce qui coïncide également avec les fonctions annulées par le laplacien h = 0 [cf. POTENTIEL ET FONCTIONS HARMONIQUES].Terminons par deux exemples d’un autre type.Exemple 5 : Soit X une variable aléatoire intégrable et (face=F0021 杻t ) une filtration; alors le processus Xt = E(X| 杻t ) est une martingale relativement à 杻t (c’est évident).Les variables aléatoires Xt s’interprètent ici comme les estimées d’une seule variable aléatoire X relativement à une information 杻t qui s’enrichit quand t croît. Nous verrons l’importance de cet exemple par la suite.Exemple 6 : dérivation. Considérons l’espace probabilisé ([0, 1], 龍,), où 龍 désigne la tribu des boréliens de [0, 1] et la mesure de Lebesgue [cf. INTÉGRATION ET MESURE]. Soit f une variable aléatoire définie sur cet espace. Posons:

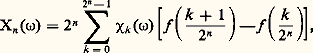

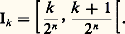

ce qui correspond à la définition des fonctions harmoniques au sens usuel sur le disque, ce qui coïncide également avec les fonctions annulées par le laplacien h = 0 [cf. POTENTIEL ET FONCTIONS HARMONIQUES].Terminons par deux exemples d’un autre type.Exemple 5 : Soit X une variable aléatoire intégrable et (face=F0021 杻t ) une filtration; alors le processus Xt = E(X| 杻t ) est une martingale relativement à 杻t (c’est évident).Les variables aléatoires Xt s’interprètent ici comme les estimées d’une seule variable aléatoire X relativement à une information 杻t qui s’enrichit quand t croît. Nous verrons l’importance de cet exemple par la suite.Exemple 6 : dérivation. Considérons l’espace probabilisé ([0, 1], 龍,), où 龍 désigne la tribu des boréliens de [0, 1] et la mesure de Lebesgue [cf. INTÉGRATION ET MESURE]. Soit f une variable aléatoire définie sur cet espace. Posons: où 﨑k est la fonction caractéristique de l’intervalle:

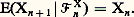

où 﨑k est la fonction caractéristique de l’intervalle: Soit aussi 杻n engendrée par la partitionIk, avec k = 0, ..., 2n 漣 1. Alors, on peut voir que (Xn , 杻n ) est une martingale.On verra, en un sens à préciser, que Xn converge presque sûrement et peut, sous de bonnes conditions, s’identifier à la dérivée de f .Nous donnerons, paragraphe 4, deux autres exemples qui concernent le «mouvement brownien» et le «processus de Poisson».3. Martingales à temps discret et théorèmes de convergenceLe cœur de cette partie est l’étude des théorèmes de convergence. Nous donnerons quelques idées sur le théorème d’arrêt, les résultats de convergence, les inégalités et quelques applications.Théorème d’arrêtL’idée essentielle contenue dans ce paragraphe est la suivante. Pour un jeu équitable, dans un intervalle de temps borné , il n’existe pas de «stratégie» (c’est-à-dire de façon de miser et de quitter le jeu en tenant compte uniquement des coups passés) qui permette de gagner. Ainsi la stratégie «bête» de l’exemple 1 n’est-elle pas plus bête qu’une autre.En termes mathématiques, cela se traduit de la manière suivante: le caractère de martingale d’un processus n’est pas affecté par un temps d’arrêt. Plus précisément:– on dit qu’une variable aléatoire T à valeurs dans N est un temps d’arrêt par rapport à une filtration (face=F0021 杻n ) si, pour tout entier n ,T = n, est 杻n -mesurable: autrement dit, en termes de jeux, l’instant T où on décide de quitter le jeu ne dépend pas des informations connues à ce moment-là.– Si T est un temps d’arrêt relativement à (face=F0021 杻n ), on définit la tribu 杻T (dite tribu associée à l’instant aléatoire T) par l’ensemble des événements A tels que A 惡T = n soit 杻n -mesurable.Moralement, c’est la tribu des événements antérieurs à T: si T( 諸) = n 0 fixé, on retrouve bien 杻n 0.Théorème . Si S et T sont deux temps d’arrêt bornés vérifiant S 諒 T, alors

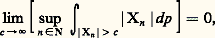

Soit aussi 杻n engendrée par la partitionIk, avec k = 0, ..., 2n 漣 1. Alors, on peut voir que (Xn , 杻n ) est une martingale.On verra, en un sens à préciser, que Xn converge presque sûrement et peut, sous de bonnes conditions, s’identifier à la dérivée de f .Nous donnerons, paragraphe 4, deux autres exemples qui concernent le «mouvement brownien» et le «processus de Poisson».3. Martingales à temps discret et théorèmes de convergenceLe cœur de cette partie est l’étude des théorèmes de convergence. Nous donnerons quelques idées sur le théorème d’arrêt, les résultats de convergence, les inégalités et quelques applications.Théorème d’arrêtL’idée essentielle contenue dans ce paragraphe est la suivante. Pour un jeu équitable, dans un intervalle de temps borné , il n’existe pas de «stratégie» (c’est-à-dire de façon de miser et de quitter le jeu en tenant compte uniquement des coups passés) qui permette de gagner. Ainsi la stratégie «bête» de l’exemple 1 n’est-elle pas plus bête qu’une autre.En termes mathématiques, cela se traduit de la manière suivante: le caractère de martingale d’un processus n’est pas affecté par un temps d’arrêt. Plus précisément:– on dit qu’une variable aléatoire T à valeurs dans N est un temps d’arrêt par rapport à une filtration (face=F0021 杻n ) si, pour tout entier n ,T = n, est 杻n -mesurable: autrement dit, en termes de jeux, l’instant T où on décide de quitter le jeu ne dépend pas des informations connues à ce moment-là.– Si T est un temps d’arrêt relativement à (face=F0021 杻n ), on définit la tribu 杻T (dite tribu associée à l’instant aléatoire T) par l’ensemble des événements A tels que A 惡T = n soit 杻n -mesurable.Moralement, c’est la tribu des événements antérieurs à T: si T( 諸) = n 0 fixé, on retrouve bien 杻n 0.Théorème . Si S et T sont deux temps d’arrêt bornés vérifiant S 諒 T, alors presque sûrement.Il en résulte, en prenant l’espérance des deux membres, que E(XT) = E(X0) pour tout temps d’arrêt T borné. Réciproquement, on peut montrer que, si un processus vérifie cette propriété, c’est une martingale. En termes de jeux, si Xn représente le gain cumulé en n coups dans un jeu équitable (avec X0 = 0), l’égalité E(XT) = E(X0) signifie bien que l’espérance du gain reste nulle quelle que soit la stratégie adoptée.Si le temps d’arrêt T n’est pas borné, l’égalité E(XT) = E(X0) ne subsiste pas nécessairement, comme le montre l’exemple 2; en effet, dans cet exemple, appelons T le premier instant où la pièce tombe sur pile, T est un temps d’arrêt et XT = 1 presque sûrement, alors que E(X0) = 0.En fait, dans la pratique, une telle stratégie n’est pas si facile à adopter car le joueur ne peut avoir un capital suffisant pour supporter des pertes arbitrairement grandes. Ainsi donc la stratégie «futée» n’est-elle futée que pour les riches.Faisons toutefois, sans insister, la remarque suivante: si S et T sont des temps d’arrêt non bornés et si la famille (Xn ) est uniformément intégrable , c’est-à-dire si:

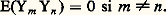

presque sûrement.Il en résulte, en prenant l’espérance des deux membres, que E(XT) = E(X0) pour tout temps d’arrêt T borné. Réciproquement, on peut montrer que, si un processus vérifie cette propriété, c’est une martingale. En termes de jeux, si Xn représente le gain cumulé en n coups dans un jeu équitable (avec X0 = 0), l’égalité E(XT) = E(X0) signifie bien que l’espérance du gain reste nulle quelle que soit la stratégie adoptée.Si le temps d’arrêt T n’est pas borné, l’égalité E(XT) = E(X0) ne subsiste pas nécessairement, comme le montre l’exemple 2; en effet, dans cet exemple, appelons T le premier instant où la pièce tombe sur pile, T est un temps d’arrêt et XT = 1 presque sûrement, alors que E(X0) = 0.En fait, dans la pratique, une telle stratégie n’est pas si facile à adopter car le joueur ne peut avoir un capital suffisant pour supporter des pertes arbitrairement grandes. Ainsi donc la stratégie «futée» n’est-elle futée que pour les riches.Faisons toutefois, sans insister, la remarque suivante: si S et T sont des temps d’arrêt non bornés et si la famille (Xn ) est uniformément intégrable , c’est-à-dire si: alors, la conclusion du théorème d’arrêt reste encore vraie.Avec des modifications évidentes, des théorèmes du même type peuvent être énoncés pour les sur-martingales et pour les sous-martingales. Ces résultats assez simples ont une signification relativement concrète, mais ils servent aussi d’outils pour l’étude générale des martingales.Théorème de convergenceLes résultats que nous allons présenter ici constituent une partie importante (élaborée, pour l’essentiel, après la Seconde Guerre mondiale par J. L. Doob) de la théorie des martingales.Commençons par une remarque simple: soit 杻n une suite croissante de tribus. Si (Xn , 杻n ) est une martingale, la suite Yn =Xn 漣 Xn-1 vérifie E(Yn | 杻n- 1) = 0; réciproquement, si Yn est une suite adaptée à 杻n telle que E(Yn | 杻n-1 ) = 0, alors Xn = Y1 + ... + Yn est une martingale relativement à Fn .On dit, dans ce cas, que la suite (Yn , 杻n ) est une suite d’accroissements de martingales. Si les Yn sont de carré intégrable, il est alors clair que (Yn ) est une suite orthogonale:

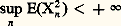

alors, la conclusion du théorème d’arrêt reste encore vraie.Avec des modifications évidentes, des théorèmes du même type peuvent être énoncés pour les sur-martingales et pour les sous-martingales. Ces résultats assez simples ont une signification relativement concrète, mais ils servent aussi d’outils pour l’étude générale des martingales.Théorème de convergenceLes résultats que nous allons présenter ici constituent une partie importante (élaborée, pour l’essentiel, après la Seconde Guerre mondiale par J. L. Doob) de la théorie des martingales.Commençons par une remarque simple: soit 杻n une suite croissante de tribus. Si (Xn , 杻n ) est une martingale, la suite Yn =Xn 漣 Xn-1 vérifie E(Yn | 杻n- 1) = 0; réciproquement, si Yn est une suite adaptée à 杻n telle que E(Yn | 杻n-1 ) = 0, alors Xn = Y1 + ... + Yn est une martingale relativement à Fn .On dit, dans ce cas, que la suite (Yn , 杻n ) est une suite d’accroissements de martingales. Si les Yn sont de carré intégrable, il est alors clair que (Yn ) est une suite orthogonale: Le cas le plus classique, on l’a vu, est celui où les (Yn ) forment une suite de variables aléatoires indépendantes et centrées, de même loi ou non (cf. Exemple 1 ). Les théorèmes de convergence célèbres du calcul des probabilités (cf. calcul des PROBABILITÉS) sont relatifs à ce cas:– les critères de convergence des séries (théorème des trois séries de Kolmogorov...),– la loi forte des grands nombres,– le théorème limite central,– la loi du logarithme itéré.Disons grossièrement que, pour les martingales, «les choses se passent à peu près de la même façon» que dans ce cadre classique.Plus précisément, soit (Xn , 杻n ) une martingale, avec Xn = Y1 + ... + Yn . Donnons quelques résultats de convergence.Théorème 1 : convergence des martingales de carré intégrable. Si on a une des deux conditions équivalentes suivantes:

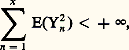

Le cas le plus classique, on l’a vu, est celui où les (Yn ) forment une suite de variables aléatoires indépendantes et centrées, de même loi ou non (cf. Exemple 1 ). Les théorèmes de convergence célèbres du calcul des probabilités (cf. calcul des PROBABILITÉS) sont relatifs à ce cas:– les critères de convergence des séries (théorème des trois séries de Kolmogorov...),– la loi forte des grands nombres,– le théorème limite central,– la loi du logarithme itéré.Disons grossièrement que, pour les martingales, «les choses se passent à peu près de la même façon» que dans ce cadre classique.Plus précisément, soit (Xn , 杻n ) une martingale, avec Xn = Y1 + ... + Yn . Donnons quelques résultats de convergence.Théorème 1 : convergence des martingales de carré intégrable. Si on a une des deux conditions équivalentes suivantes: ou:

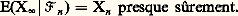

ou: alors Xn converge presque sûrement et dans L2 vers une variable aléatoire X size=1秊.La convergence reste vraie dans un cadre plus général. Si f est une fonction quelconque, on désigne par f + la fonction sup (f , 0) et par f - la fonction sup (0, 漣 f ). On a alors les résultats suivants.Théorème 2: Si (Xn , 杻n ) est une sur-martingale et si sup E(Xn ) 麗 秊, alors n Xn converge presque sûrement vers une variable aléatoire X size=1秊 (cela est en particulier réalisé si les Xn sont positives ou nulles).Théorème 2 bis: Lorsque la convergence de (Xn ) vers X size=1秊 a lieu aussi dans L1( 行, 杻, p ), on a:

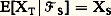

alors Xn converge presque sûrement et dans L2 vers une variable aléatoire X size=1秊.La convergence reste vraie dans un cadre plus général. Si f est une fonction quelconque, on désigne par f + la fonction sup (f , 0) et par f - la fonction sup (0, 漣 f ). On a alors les résultats suivants.Théorème 2: Si (Xn , 杻n ) est une sur-martingale et si sup E(Xn ) 麗 秊, alors n Xn converge presque sûrement vers une variable aléatoire X size=1秊 (cela est en particulier réalisé si les Xn sont positives ou nulles).Théorème 2 bis: Lorsque la convergence de (Xn ) vers X size=1秊 a lieu aussi dans L1( 行, 杻, p ), on a: Autrement dit, la martingale (Xn , 杻n ) est du type introduit dans l’exemple 5. C’est le cas si et seulement si la famille (Xn ), n 捻 N, est uniformément intégrable.On fera les remarques suivantes:– il existe des martingales qui ne convergent pas (c’est le cas de l’exemple 1);– si une martingale converge presque sûrement, on n’est pas nécessairement dans le cas du théorème 2 bis , c’est-à-dire qu’on ne peut pas toujours reconstituer (Xn ) à partir de sa limite presque sûre X size=1秊 (cf. l’exemple 2, où la limite presque sûre est évidemment 1).De ces théorèmes on peut déduire des analogues de la loi des grands nombres, c’est-à-dire donner des conditions pour que:

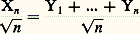

Autrement dit, la martingale (Xn , 杻n ) est du type introduit dans l’exemple 5. C’est le cas si et seulement si la famille (Xn ), n 捻 N, est uniformément intégrable.On fera les remarques suivantes:– il existe des martingales qui ne convergent pas (c’est le cas de l’exemple 1);– si une martingale converge presque sûrement, on n’est pas nécessairement dans le cas du théorème 2 bis , c’est-à-dire qu’on ne peut pas toujours reconstituer (Xn ) à partir de sa limite presque sûre X size=1秊 (cf. l’exemple 2, où la limite presque sûre est évidemment 1).De ces théorèmes on peut déduire des analogues de la loi des grands nombres, c’est-à-dire donner des conditions pour que: converge presque sûrement vers 0.Ce qui précède indique que la notion de martingale est bien adaptée à l’obtention de convergences presque sûres.Il est remarquable de constater que la notion de martingale sert aussi pour les convergences en loi: on a, par exemple, l’analogue suivant du théorème limite central.Théorème 3: Soit (Xn , 杻n ) une martingale, avec Xn = Y1 + ... + Yn . Si (Yn ) est stationnaire et ergodique (cf. théorie ERGODIQUE) et si elle admet un moment d’ordre 2, c’est-à-dire E(Y12) = 靖2 麗 秊, alors:

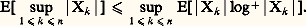

converge presque sûrement vers 0.Ce qui précède indique que la notion de martingale est bien adaptée à l’obtention de convergences presque sûres.Il est remarquable de constater que la notion de martingale sert aussi pour les convergences en loi: on a, par exemple, l’analogue suivant du théorème limite central.Théorème 3: Soit (Xn , 杻n ) une martingale, avec Xn = Y1 + ... + Yn . Si (Yn ) est stationnaire et ergodique (cf. théorie ERGODIQUE) et si elle admet un moment d’ordre 2, c’est-à-dire E(Y12) = 靖2 麗 秊, alors: converge en loi vers une variable aléatoire gaussienne centrée de variance 靖2.À noter que ce théorème peut servir de point de départ pour obtenir des résultats de convergence en loi dans des situations très variées (en théorie ergodique, pour les chaînes de Markov...).Plus généralement, des efforts divers ont été entrepris pour définir de diverses manières des notions de martingales, disons «approchées», et conserver ainsi certains théorèmes de convergences recouvrant dans le même temps le cas d’autres processus.InégalitésLes démonstrations des théorèmes de convergence pour les martingales reposent sur un certain nombre d’inégalités qui ont d’ailleurs un intérêt en soi. Les inégalités de base sont du même type que l’inégalité de Kolmogorov (cf. calcul des PROBABILITÉS).Pour expliquer cela, rappelons que si (Zn ) est une suite de variables aléatoires quelconque, la convergence en loi de la suite Zn ne change pas si l’on remplace la suite par une suite Z n telle que, pour tout n , Zn et Z n aient même loi, quelles que soient les conditions de dépendance des Z n entre elles; alors qu’une convergence presque sûre exprime une propriété de la loi conjointe de toutes les Zn .Des inégalités du type Bienaymé-Tchebycheff sont souvent utiles à des convergences en loi ou dans Lp , alors que des inégalités (plus difficiles!) du type Kolmogorov sont en général nécessaires pour obtenir des convergences presque sûres.Donnons quelques inégalités importantes qui permettent de majorer

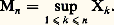

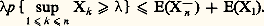

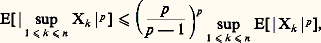

converge en loi vers une variable aléatoire gaussienne centrée de variance 靖2.À noter que ce théorème peut servir de point de départ pour obtenir des résultats de convergence en loi dans des situations très variées (en théorie ergodique, pour les chaînes de Markov...).Plus généralement, des efforts divers ont été entrepris pour définir de diverses manières des notions de martingales, disons «approchées», et conserver ainsi certains théorèmes de convergences recouvrant dans le même temps le cas d’autres processus.InégalitésLes démonstrations des théorèmes de convergence pour les martingales reposent sur un certain nombre d’inégalités qui ont d’ailleurs un intérêt en soi. Les inégalités de base sont du même type que l’inégalité de Kolmogorov (cf. calcul des PROBABILITÉS).Pour expliquer cela, rappelons que si (Zn ) est une suite de variables aléatoires quelconque, la convergence en loi de la suite Zn ne change pas si l’on remplace la suite par une suite Z n telle que, pour tout n , Zn et Z n aient même loi, quelles que soient les conditions de dépendance des Z n entre elles; alors qu’une convergence presque sûre exprime une propriété de la loi conjointe de toutes les Zn .Des inégalités du type Bienaymé-Tchebycheff sont souvent utiles à des convergences en loi ou dans Lp , alors que des inégalités (plus difficiles!) du type Kolmogorov sont en général nécessaires pour obtenir des convergences presque sûres.Donnons quelques inégalités importantes qui permettent de majorer

Citons aussi les inégalités suivantes, qui sont liées à la précédente:– si X n 捻 L p, avec p 礪 1, alors:

Citons aussi les inégalités suivantes, qui sont liées à la précédente:– si X n 捻 L p, avec p 礪 1, alors: ce qui signifie, entre autres, que Mn est dans Lp ;– si Xn 捻 L1, alors:

ce qui signifie, entre autres, que Mn est dans Lp ;– si Xn 捻 L1, alors: Notons que, alors, Mn n’est pas nécessairement dans L1.Il est intéressant de remarquer la similitude de ces inégalités et théorèmes de convergence avec les résultats correspondants de théorie ergodique (cf. théorie ERGODIQUE). Des efforts ont été faits pour relier et unifier ces deux théories.ApplicationsVoyons brièvement ce que signifient ces théorèmes de convergence sur quelques exemples.1. Dans l’exemple 6 (cf. supra ) supposons la fonction f croissante, alors sup E(Xn ) n est fini, et le théorème 2 nous indique que Xn converge presque sûrement vers une variable aléatoire X size=1秊. Un raisonnement plus poussé permet alors d’identifier X size=1秊 à la dérivée de f .Ce genre d’idées est intéressant dans des cadres plus généraux qu’il est difficile d’expliquer en quelques lignes.2. Considérons maintenant l’exemple 3 des fonctions harmoniques: si h est une fonction harmonique, il est clair que la martingale Xn = h (x n ) qui est bornée converge presque sûrement grâce au théorème 1 ou 2.En particulier, lorsque h est une des deux fonctions coordonnées, il est évident que h ne peut converger suivant une trajectoire x n que si x n est fixe à partir d’un certain rang. Il s’ensuit que presque toutes les trajectoires arrivent en un point de 煉C et y restent.Regardons maintenant le premier instant où (x n ) arrive au bord, c’est-à-dire la variable aléatoire:

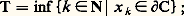

Notons que, alors, Mn n’est pas nécessairement dans L1.Il est intéressant de remarquer la similitude de ces inégalités et théorèmes de convergence avec les résultats correspondants de théorie ergodique (cf. théorie ERGODIQUE). Des efforts ont été faits pour relier et unifier ces deux théories.ApplicationsVoyons brièvement ce que signifient ces théorèmes de convergence sur quelques exemples.1. Dans l’exemple 6 (cf. supra ) supposons la fonction f croissante, alors sup E(Xn ) n est fini, et le théorème 2 nous indique que Xn converge presque sûrement vers une variable aléatoire X size=1秊. Un raisonnement plus poussé permet alors d’identifier X size=1秊 à la dérivée de f .Ce genre d’idées est intéressant dans des cadres plus généraux qu’il est difficile d’expliquer en quelques lignes.2. Considérons maintenant l’exemple 3 des fonctions harmoniques: si h est une fonction harmonique, il est clair que la martingale Xn = h (x n ) qui est bornée converge presque sûrement grâce au théorème 1 ou 2.En particulier, lorsque h est une des deux fonctions coordonnées, il est évident que h ne peut converger suivant une trajectoire x n que si x n est fixe à partir d’un certain rang. Il s’ensuit que presque toutes les trajectoires arrivent en un point de 煉C et y restent.Regardons maintenant le premier instant où (x n ) arrive au bord, c’est-à-dire la variable aléatoire: T est un temps d’arrêt relativement à la filtration naturelle de (x n ). Si l’état initial 﨡 est déjà sur le bord 煉C, nous avons T = 0; supposons donc que 﨡 捻 C 漣 煉C. Le théorème d’arrêt appliqué à S = 0 et à T nous dit que:

T est un temps d’arrêt relativement à la filtration naturelle de (x n ). Si l’état initial 﨡 est déjà sur le bord 煉C, nous avons T = 0; supposons donc que 﨡 捻 C 漣 煉C. Le théorème d’arrêt appliqué à S = 0 et à T nous dit que: Désignons alors par 神( 﨡, 兀) la probabilité pour que la chaîne partant de 﨡 aboutisse à 兀 捻 煉C. L’égalité ci-dessus s’écrit alors:

Désignons alors par 神( 﨡, 兀) la probabilité pour que la chaîne partant de 﨡 aboutisse à 兀 捻 煉C. L’égalité ci-dessus s’écrit alors: ce qui prouve qu’une fonction harmonique sur C est entièrement déterminée par ses valeurs sur le bord 煉C. C’est la solution du fameux «problème de Dirichlet», la formule ci-dessus n’étant autre qu’une «formule de Poisson»: nous allons préciser cela.Remarquons aussi que, dans le cas (d = 1) du jeu de pile ou face «contre la banque», C = [a , b ], 煉C =a , b, la fonction h : x 料 x est évidemment harmonique. Si le gain initial 﨡 est nul (x 0 = 0), alors 神(0, a ) est la probabilité de ruine du joueur et 神(0, b ) la probabilité de faire sauter la banque. La formule de Poisson ci-dessus s’écrit donc:

ce qui prouve qu’une fonction harmonique sur C est entièrement déterminée par ses valeurs sur le bord 煉C. C’est la solution du fameux «problème de Dirichlet», la formule ci-dessus n’étant autre qu’une «formule de Poisson»: nous allons préciser cela.Remarquons aussi que, dans le cas (d = 1) du jeu de pile ou face «contre la banque», C = [a , b ], 煉C =a , b, la fonction h : x 料 x est évidemment harmonique. Si le gain initial 﨡 est nul (x 0 = 0), alors 神(0, a ) est la probabilité de ruine du joueur et 神(0, b ) la probabilité de faire sauter la banque. La formule de Poisson ci-dessus s’écrit donc: Le fait que presque toutes les trajectoires (x n = h (x n )) convergent vers un point du bord, c’est-à-dire vers a ou b , signifie qu’on aboutit presque sûrement à ruiner le joueur ou à faire sauter la banque, donc:

Le fait que presque toutes les trajectoires (x n = h (x n )) convergent vers un point du bord, c’est-à-dire vers a ou b , signifie qu’on aboutit presque sûrement à ruiner le joueur ou à faire sauter la banque, donc: à partir de cette remarque et de la formule de Poisson, on calcule évidemment 神(0, a ) et 神(0, b ). Comme la fortune initiale |a | du joueur est beaucoup plus faible que celle b de la banque, il est clair que la probabilité 神(0, b ) de faire sauter la banque va être très petite.3. Fonctions 猪-harmoniques. Plaçons-nous dans le cadre de l’exemple 4 des fonctions harmoniques pour une chaîne de Markov et considérons le cas où l’espace des états E est un groupe localement compact connexe G et où la probabilité de transition est invariante par l’action de G, c’est-à-dire, pour tout g 捻 G:

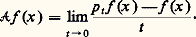

à partir de cette remarque et de la formule de Poisson, on calcule évidemment 神(0, a ) et 神(0, b ). Comme la fortune initiale |a | du joueur est beaucoup plus faible que celle b de la banque, il est clair que la probabilité 神(0, b ) de faire sauter la banque va être très petite.3. Fonctions 猪-harmoniques. Plaçons-nous dans le cadre de l’exemple 4 des fonctions harmoniques pour une chaîne de Markov et considérons le cas où l’espace des états E est un groupe localement compact connexe G et où la probabilité de transition est invariante par l’action de G, c’est-à-dire, pour tout g 捻 G: On montre facilement que cela revient à choisir une mesure de probabilité 猪 sur G et à considérer l’opérateur P:

On montre facilement que cela revient à choisir une mesure de probabilité 猪 sur G et à considérer l’opérateur P: Le problème est le suivant: trouver toutes les fonctions P-harmoniques (on dit ici 猪-harmoniques!) bornées, c’est-à-dire telles que:

Le problème est le suivant: trouver toutes les fonctions P-harmoniques (on dit ici 猪-harmoniques!) bornées, c’est-à-dire telles que: en particulier, trouver des conditions sur G et 猪 pour que toutes les fonctions 猪-harmoniques bornées soient constantes; et, lorsque ce n’est pas le cas, donner une «formule de Poisson», c’est-à-dire une formule qui permette de représenter toutes les fonctions 猪-harmoniques bornées au moyen de leurs valeurs «au bord de G», la notion de «bord de G» étant évidemment à préciser.Cette étude est justifiée en particulier par les deux remarques suivantes:– si le groupe G est abélien, et moyennant une faible hypothèse raisonnable sur 猪, toutes les fonctions 猪-harmoniques bornées sont constantes (ce qui, dans le cas de G = Rd , correspond à la classique propriété de Liouville);– si G est le groupe des matrices 2 憐 2 réelles de déterminant 1 (habituellement noté SL(2, R)) et si 猪 satisfait certaines propriétés raisonnables d’invariance, alors les fonctions 猪-harmoniques correspondent aux fonctions harmoniques au sens usuel sur le disque.Pour résoudre le problème général ci-dessus, à savoir décrire toutes les fonctions 猪-harmoniques bornées, la théorie des martingales est un argument crucial afin d’obtenir une «formule de Poisson», et est très utilisée en finance mathématique.Des résultats du même type existent pour les solutions d’équations aux dérivées partielles elliptiques du second ordre [cf. POTENTIEL ET FONCTIONS HARMONIQUES].4. Martingales à temps continu et semi-martingalesPour les martingales à temps continu, on a des résultats analogues à ceux qui ont été décrits ci-dessus dans le cas du temps discret; mais leur étude (et celle des processus qui y sont rattachés, les semi-martingales) tire aussi son origine des propriétés de martingales associées à deux processus stochastiques qui jouent un rôle fondamental: le mouvement brownien (ou processus de Wiener ) et le processus de Poisson .L’intérêt de cette étude est ensuite accru par la construction de l’intégrale stochastique, la résolution d’équations différentielles stochastiques par rapport aux semi-martingales qui permettent de développer un calcul stochastique à temps continu. Les applications en sont nombreuses, autant dans d’autres branches des mathématiques que pour la modélisation de certains phénomènes physiques.Dans tout ce paragraphe I = [0, 秊[.ExemplesExemple 7 : Soit (Nt ), t 閭 0, le processus de comptage de Poisson [cf. STOCHASTIQUES (PROCESSUS)] de paramètre 1 et (face=F0021 杻t ), t 閭 0, la filtration naturelle de (Nt ), t 閭 0. La propriété pour (Nt ), t 閭 0, d’avoir ses accroissements indépendants permet d’obtenir que, avec t 閭 0,

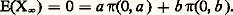

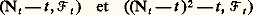

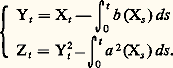

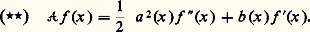

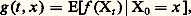

en particulier, trouver des conditions sur G et 猪 pour que toutes les fonctions 猪-harmoniques bornées soient constantes; et, lorsque ce n’est pas le cas, donner une «formule de Poisson», c’est-à-dire une formule qui permette de représenter toutes les fonctions 猪-harmoniques bornées au moyen de leurs valeurs «au bord de G», la notion de «bord de G» étant évidemment à préciser.Cette étude est justifiée en particulier par les deux remarques suivantes:– si le groupe G est abélien, et moyennant une faible hypothèse raisonnable sur 猪, toutes les fonctions 猪-harmoniques bornées sont constantes (ce qui, dans le cas de G = Rd , correspond à la classique propriété de Liouville);– si G est le groupe des matrices 2 憐 2 réelles de déterminant 1 (habituellement noté SL(2, R)) et si 猪 satisfait certaines propriétés raisonnables d’invariance, alors les fonctions 猪-harmoniques correspondent aux fonctions harmoniques au sens usuel sur le disque.Pour résoudre le problème général ci-dessus, à savoir décrire toutes les fonctions 猪-harmoniques bornées, la théorie des martingales est un argument crucial afin d’obtenir une «formule de Poisson», et est très utilisée en finance mathématique.Des résultats du même type existent pour les solutions d’équations aux dérivées partielles elliptiques du second ordre [cf. POTENTIEL ET FONCTIONS HARMONIQUES].4. Martingales à temps continu et semi-martingalesPour les martingales à temps continu, on a des résultats analogues à ceux qui ont été décrits ci-dessus dans le cas du temps discret; mais leur étude (et celle des processus qui y sont rattachés, les semi-martingales) tire aussi son origine des propriétés de martingales associées à deux processus stochastiques qui jouent un rôle fondamental: le mouvement brownien (ou processus de Wiener ) et le processus de Poisson .L’intérêt de cette étude est ensuite accru par la construction de l’intégrale stochastique, la résolution d’équations différentielles stochastiques par rapport aux semi-martingales qui permettent de développer un calcul stochastique à temps continu. Les applications en sont nombreuses, autant dans d’autres branches des mathématiques que pour la modélisation de certains phénomènes physiques.Dans tout ce paragraphe I = [0, 秊[.ExemplesExemple 7 : Soit (Nt ), t 閭 0, le processus de comptage de Poisson [cf. STOCHASTIQUES (PROCESSUS)] de paramètre 1 et (face=F0021 杻t ), t 閭 0, la filtration naturelle de (Nt ), t 閭 0. La propriété pour (Nt ), t 閭 0, d’avoir ses accroissements indépendants permet d’obtenir que, avec t 閭 0, soient des martingales.Exemple 8: Un processus (Bt ), t 閭 0, continu, adapté à une filtration (Ft ), t 閭 0, est un mouvement brownien si, pour tout s et pour tout t positifs, la variable Bt+s 漣 Bt est indépendante de 杻t et suit une loi gaussienne centrée de variance s ; il est facile de voir, alors, que (Bt , 杻t ), t 閭 0, et (Bt 2 漣 t , 杻t ), t 諒 0, sont des martingales.Le mouvement brownien peut être considéré comme «limite» des résultats d’un jeu de pile ou face lorsqu’on jette les pièces à des instants de plus en plus rapprochés; plus précisément, si Xn = Y1 + ... + Yn est le gain cumulé par le joueur à l’instant n dans le jeu de pile ou face «bête» de l’exemple 1, on peut voir que la suite de processus

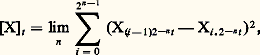

soient des martingales.Exemple 8: Un processus (Bt ), t 閭 0, continu, adapté à une filtration (Ft ), t 閭 0, est un mouvement brownien si, pour tout s et pour tout t positifs, la variable Bt+s 漣 Bt est indépendante de 杻t et suit une loi gaussienne centrée de variance s ; il est facile de voir, alors, que (Bt , 杻t ), t 閭 0, et (Bt 2 漣 t , 杻t ), t 諒 0, sont des martingales.Le mouvement brownien peut être considéré comme «limite» des résultats d’un jeu de pile ou face lorsqu’on jette les pièces à des instants de plus en plus rapprochés; plus précisément, si Xn = Y1 + ... + Yn est le gain cumulé par le joueur à l’instant n dans le jeu de pile ou face «bête» de l’exemple 1, on peut voir que la suite de processus (où [nt ] désigne la partie entière de nt , pour t 捻 R+ ) converge «en loi» vers le mouvement brownien (Bt ). Cette propriété reste vraie si (Yn ) est une suite quelconque de variables aléatoires indépendantes, de même loi, centrées, de variance 1. Ainsi donc, puisque (Xn ) est la somme de phénomènes indépendants entre eux et stationnaires, le brownien apparaît comme l’intégrale de phénomènes aléatoires infinitésimaux indépendants entre eux et stationnaires, c’est-à-dire de ce que les physiciens appellent le «bruit blanc».Régularité des trajectoiresLes trajectoires des martingales à temps continu ont des propriétés de régularité remarquables, provenant en particulier du théorème de convergence pour le cas discret: si (Xt ), t 閭 0, est une sous-martingale ou une sur-martingale, alors, en dehors d’un ensemble de probabilité nulle, la fonction r 料 Xr ( 諸) définie sur les rationnels positifs admet une limite à droite et une limite à gauche.Le théorème d’arrêt est valable pour toute sur-martingale ou bien pour toute sous-martingale continue à droite, en définissant un temps d’arrêt T, comme une application T : 行[0, 秊] telle queT 諒 t 捻 杻t pour tout t 閭 0, et 杻T étant la tribu ensemble des événements A tels que A 惡T 諒 t 捻 杻t .Et, comme on l’a dit plus haut, on a des théorèmes de convergence analogues à ceux du temps discret.Semi-martingales et variation quadratiqueUn processus (Xt ), t 閭 0, est dit à variation finie si, pour chaque 諸, la fonction t 料 Xt ( 諸) est à variation finie ou bornée [cf. INTÉGRATION ET MESURE] sur tout compact de R+: elle ne tremble qu’un peu.Certaines martingales sont à variation finie (exemple 7); par contre, le mouvement brownien n’a pas cette propriété (et même presque toutes ses trajectoires sont à variation infinie): en termes intuitifs, sur tout intervalle, si petit soit-il, la fonction t 料 Bt tremble beaucoup, presque sûrement.On peut montrer le résultat remarquable suivant: Toute martingale continue à variation finie est presque sûrement une constante . Donc elle ne tremble pas du tout.Les processus à variation finie s’introduisent naturellement dans la modélisation de phénomènes réels, mais, comme on l’a vu plus haut (exemple 8), le mouvement brownien aussi; c’est pourquoi il est intéressant d’introduire une famille de processus contenant à la fois les processus à variation finie et les martingales, la famille des semi-martingales ; une semi-martingale (Xt ),t 閭 0, relative à une filtration (face=F0021 杻t ) est un processus s’écrivant sous la forme Xt = At + Mt , où (At ), t 閭 0, est un processus à variation finie et (Mt , 杻t ), t 閭 0, est localement une martingale (c’est-à-dire qu’il existe une suite (Tn ) de temps d’arrêt croissant presque sûrement vers l’infini et telle que, pour chaque n , le processus (Mt size=1廬T n ), t 閭 0, soit une martingale).Toute martingale, mais aussi toute sous-martingale ou sur-martingale est une semi-martingale. La classe des semi-martingales possède toute une série de propriétés de permanence (stabilité par arrêt, par changement absolument continu de probabilité, par changement de filtration, par changement de temps...) qui en fait une notion fondamentale.Voici une autre propriété essentielle: Soit (Xt ), t 閭 0, une semi-martingale; il existe un processus croissant fini noté ([X]t ), t 閭 0, tel que:

(où [nt ] désigne la partie entière de nt , pour t 捻 R+ ) converge «en loi» vers le mouvement brownien (Bt ). Cette propriété reste vraie si (Yn ) est une suite quelconque de variables aléatoires indépendantes, de même loi, centrées, de variance 1. Ainsi donc, puisque (Xn ) est la somme de phénomènes indépendants entre eux et stationnaires, le brownien apparaît comme l’intégrale de phénomènes aléatoires infinitésimaux indépendants entre eux et stationnaires, c’est-à-dire de ce que les physiciens appellent le «bruit blanc».Régularité des trajectoiresLes trajectoires des martingales à temps continu ont des propriétés de régularité remarquables, provenant en particulier du théorème de convergence pour le cas discret: si (Xt ), t 閭 0, est une sous-martingale ou une sur-martingale, alors, en dehors d’un ensemble de probabilité nulle, la fonction r 料 Xr ( 諸) définie sur les rationnels positifs admet une limite à droite et une limite à gauche.Le théorème d’arrêt est valable pour toute sur-martingale ou bien pour toute sous-martingale continue à droite, en définissant un temps d’arrêt T, comme une application T : 行[0, 秊] telle queT 諒 t 捻 杻t pour tout t 閭 0, et 杻T étant la tribu ensemble des événements A tels que A 惡T 諒 t 捻 杻t .Et, comme on l’a dit plus haut, on a des théorèmes de convergence analogues à ceux du temps discret.Semi-martingales et variation quadratiqueUn processus (Xt ), t 閭 0, est dit à variation finie si, pour chaque 諸, la fonction t 料 Xt ( 諸) est à variation finie ou bornée [cf. INTÉGRATION ET MESURE] sur tout compact de R+: elle ne tremble qu’un peu.Certaines martingales sont à variation finie (exemple 7); par contre, le mouvement brownien n’a pas cette propriété (et même presque toutes ses trajectoires sont à variation infinie): en termes intuitifs, sur tout intervalle, si petit soit-il, la fonction t 料 Bt tremble beaucoup, presque sûrement.On peut montrer le résultat remarquable suivant: Toute martingale continue à variation finie est presque sûrement une constante . Donc elle ne tremble pas du tout.Les processus à variation finie s’introduisent naturellement dans la modélisation de phénomènes réels, mais, comme on l’a vu plus haut (exemple 8), le mouvement brownien aussi; c’est pourquoi il est intéressant d’introduire une famille de processus contenant à la fois les processus à variation finie et les martingales, la famille des semi-martingales ; une semi-martingale (Xt ),t 閭 0, relative à une filtration (face=F0021 杻t ) est un processus s’écrivant sous la forme Xt = At + Mt , où (At ), t 閭 0, est un processus à variation finie et (Mt , 杻t ), t 閭 0, est localement une martingale (c’est-à-dire qu’il existe une suite (Tn ) de temps d’arrêt croissant presque sûrement vers l’infini et telle que, pour chaque n , le processus (Mt size=1廬T n ), t 閭 0, soit une martingale).Toute martingale, mais aussi toute sous-martingale ou sur-martingale est une semi-martingale. La classe des semi-martingales possède toute une série de propriétés de permanence (stabilité par arrêt, par changement absolument continu de probabilité, par changement de filtration, par changement de temps...) qui en fait une notion fondamentale.Voici une autre propriété essentielle: Soit (Xt ), t 閭 0, une semi-martingale; il existe un processus croissant fini noté ([X]t ), t 閭 0, tel que: où la limite est prise en probabilité et où elle porte sur la suite des partitions dyadiques 戮n =Ik ; k = 0, ..., 2n 漣 1, avec Ik = [k 2-n ,(k + 1)2-n [. Ce processus est appelé la variation quadratique de X.Il est alors clair qu’il est «plus facile» pour un processus d’avoir une variation quadratique finie que d’avoir une variation finie (par exemple, on peut montrer qu’une fonction continue à variation finie a une variation quadratique nulle). En termes imagés, on pourrait dire que, presque sûrement pour une martingale, la fonction t 料 Xt tremble beaucoup, mais pas à la folie.Les problèmes de martingalesPour l’identification de processus limites, ainsi que pour la mise en place d’un calcul intégral adapté aux modèles aléatoires, la notion de martingale joue encore un rôle essentiel.On a vu que, si (Bt ), t 閭 0, est un mouvement brownien, alors (Bt , 杻t ), t 閭 0, et (Bt 2 漣 t , 杻t ), t 閭 0, sont des martingales; mais la réciproque est vraie: si (Xt , 杻t ), t 閭 0, est une martingale continue nulle en 0 telle que (Xt 2 漣 t , 杻t ), t 閭 0, soit une martingale, alors (Xt ), t 閭 0, est un mouvement brownien. Cette caractérisation nous conduit à introduire ce qu’on appelle un problème de martingales : Soit 栗 une famille de processus sur ( 行, 杻) adaptés à (face=F0021 杻t ), t 閭 0; on appelle solution du problème des martingales 栗 toute probabilité p sur ( 行, 杻) telle que chaque élément de 栗 soit une martingale.Ainsi, si 行 est l’espace des fonctions continues sur R+, 諸: [0, 秊[R telles que 諸(0) = 0, 杻 la tribu des boréliens de 行, si Xt ( 諸) = 諸(t ) et Zt ( 諸) = 諸2(t ) 漣 t , l’unique solution du problème de martingales 栗 =X, Z est la probabilité p sur ( 行, 杻) qui fait de X un mouvement brownien.Nous introduisons plus loin un autre problème de martingales, lié aux équations différentielles stochastiques. Auparavant, donnons une application de cette notion de problème de martingales.Reprenons la suite de variables (Yn ) modélisant le jeu de pile ou face de l’exemple 8 et soit:

où la limite est prise en probabilité et où elle porte sur la suite des partitions dyadiques 戮n =Ik ; k = 0, ..., 2n 漣 1, avec Ik = [k 2-n ,(k + 1)2-n [. Ce processus est appelé la variation quadratique de X.Il est alors clair qu’il est «plus facile» pour un processus d’avoir une variation quadratique finie que d’avoir une variation finie (par exemple, on peut montrer qu’une fonction continue à variation finie a une variation quadratique nulle). En termes imagés, on pourrait dire que, presque sûrement pour une martingale, la fonction t 料 Xt tremble beaucoup, mais pas à la folie.Les problèmes de martingalesPour l’identification de processus limites, ainsi que pour la mise en place d’un calcul intégral adapté aux modèles aléatoires, la notion de martingale joue encore un rôle essentiel.On a vu que, si (Bt ), t 閭 0, est un mouvement brownien, alors (Bt , 杻t ), t 閭 0, et (Bt 2 漣 t , 杻t ), t 閭 0, sont des martingales; mais la réciproque est vraie: si (Xt , 杻t ), t 閭 0, est une martingale continue nulle en 0 telle que (Xt 2 漣 t , 杻t ), t 閭 0, soit une martingale, alors (Xt ), t 閭 0, est un mouvement brownien. Cette caractérisation nous conduit à introduire ce qu’on appelle un problème de martingales : Soit 栗 une famille de processus sur ( 行, 杻) adaptés à (face=F0021 杻t ), t 閭 0; on appelle solution du problème des martingales 栗 toute probabilité p sur ( 行, 杻) telle que chaque élément de 栗 soit une martingale.Ainsi, si 行 est l’espace des fonctions continues sur R+, 諸: [0, 秊[R telles que 諸(0) = 0, 杻 la tribu des boréliens de 行, si Xt ( 諸) = 諸(t ) et Zt ( 諸) = 諸2(t ) 漣 t , l’unique solution du problème de martingales 栗 =X, Z est la probabilité p sur ( 行, 杻) qui fait de X un mouvement brownien.Nous introduisons plus loin un autre problème de martingales, lié aux équations différentielles stochastiques. Auparavant, donnons une application de cette notion de problème de martingales.Reprenons la suite de variables (Yn ) modélisant le jeu de pile ou face de l’exemple 8 et soit: Pour montrer que (Xt n ), t 閭 0, tend en loi vers le mouvement brownien, on prouve d’abord que les lois des (Xt n ), t 閭 0, forment un ensemble relativement compact, puis que la seule valeur d’adhérence est la loi du mouvement brownien. Pour cela, on considère une sous-suite (Xt n ), t 閭 0, dont les lois convergent vers une limite p , et il est assez facile de vérifier que p est solution du problème de martingales 栗 =X, Z ci-dessus, d’où le résultat.Ce type de démonstration se généralise à des situations très variées et est un outil puissant pour l’identification de lois de processus.5. Calcul stochastiqueConsidérons l’équation:

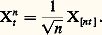

Pour montrer que (Xt n ), t 閭 0, tend en loi vers le mouvement brownien, on prouve d’abord que les lois des (Xt n ), t 閭 0, forment un ensemble relativement compact, puis que la seule valeur d’adhérence est la loi du mouvement brownien. Pour cela, on considère une sous-suite (Xt n ), t 閭 0, dont les lois convergent vers une limite p , et il est assez facile de vérifier que p est solution du problème de martingales 栗 =X, Z ci-dessus, d’où le résultat.Ce type de démonstration se généralise à des situations très variées et est un outil puissant pour l’identification de lois de processus.5. Calcul stochastiqueConsidérons l’équation: représentant, par exemple, l’évolution d’un système où intervient un bruit blanc modélisé par la «dérivée» d’un mouvement brownien (Bt ), t 閭 0; pour donner un sens à (face=F0019 列), on a besoin de définir l’intégrale du type:

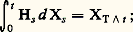

représentant, par exemple, l’évolution d’un système où intervient un bruit blanc modélisé par la «dérivée» d’un mouvement brownien (Bt ), t 閭 0; pour donner un sens à (face=F0019 列), on a besoin de définir l’intégrale du type: L’intégrale stochastique . Lorsque (Ht ), t 閭 0, est un processus convenable et (Xt ), t 閭 0, une semi-martingale, on peut définir:

L’intégrale stochastique . Lorsque (Ht ), t 閭 0, est un processus convenable et (Xt ), t 閭 0, une semi-martingale, on peut définir: car si Ht = 1 size=1索t size=1諒 T size=1參, où T est un temps d’arrêt, la seule définition naturelle est:

car si Ht = 1 size=1索t size=1諒 T size=1參, où T est un temps d’arrêt, la seule définition naturelle est: ensuite, par linéarité et continuité, cette «intégrale stochastique» se prolonge à tout H borné, mesurable par rapport à la tribu engendrée par les (Ht ), t 閭 0 de la forme ci-dessus; on montre que ce prolongement n’est possible que si (Xt ), t 閭 0 est une semi-martingale; lorsque (Xt ) est à variation finie, l’intégrale stochastique coïncide avec l’intégrale de Stieltjes; mais, lorsque (Xt ), t 閭 0, n’est pas à variation finie (par exemple si (Xt ), t 閭 0, est une martingale continue), l’intégrale de Stieltjes n’existe pas alors que l’intégrale stochastique est définie. Indiquons deux outils essentiels qui permettent de manier cette intégrale:– un théorème de convergence dominée qui s’exprime ainsi: Si une suite (Ht n ), t 閭 0, de processus intégrables converge simplement vers un processus (Ht ), t 閭 0, et si, pour tout t 閭 0, Ht n est majorée en valeur absolue par Kt où (Kt ), t 閭 0, est un processus intégrable, alors on a, au sens de la convergence en probabilité,

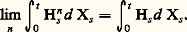

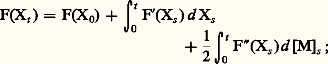

ensuite, par linéarité et continuité, cette «intégrale stochastique» se prolonge à tout H borné, mesurable par rapport à la tribu engendrée par les (Ht ), t 閭 0 de la forme ci-dessus; on montre que ce prolongement n’est possible que si (Xt ), t 閭 0 est une semi-martingale; lorsque (Xt ) est à variation finie, l’intégrale stochastique coïncide avec l’intégrale de Stieltjes; mais, lorsque (Xt ), t 閭 0, n’est pas à variation finie (par exemple si (Xt ), t 閭 0, est une martingale continue), l’intégrale de Stieltjes n’existe pas alors que l’intégrale stochastique est définie. Indiquons deux outils essentiels qui permettent de manier cette intégrale:– un théorème de convergence dominée qui s’exprime ainsi: Si une suite (Ht n ), t 閭 0, de processus intégrables converge simplement vers un processus (Ht ), t 閭 0, et si, pour tout t 閭 0, Ht n est majorée en valeur absolue par Kt où (Kt ), t 閭 0, est un processus intégrable, alors on a, au sens de la convergence en probabilité, – une formule de changement de variable (due à K. Ito dans le cas du mouvement brownien), qui permet de développer tout un calcul différentiel stochastique. Lorsque (Xt ), t 閭 0, est une semi-martingale continue de décomposition Xt = At + Mt où (Mt ), t 閭 0, est localement une martingale continue, la «formule de Ito» a la forme suivante, F désignant une fonction de variables réelles admettant des dérivées F , F continues: